Cerrar una brecha crítica de cobertura en la validación de cámaras ADAS/AD

Información general

Parte de nuestro H1 2023 Automotive Journal

Probar el software de versión de producción para sistemas de asistencia avanzada del conductor (ADAS) basados en cámaras es difícil debido a las medidas de seguridad integradas para cumplir con los requisitos de seguridad funcional. Para satisfacer las comprobaciones de validez del dispositivo bajo prueba y estimular comportamientos similares a la conducción de pruebas, NI proporciona hardware y software dedicados para emular la funcionalidad del sensor de imagen en tres capas diferentes, lo que ayuda a evitar la necesidad de un software de modo de prueba dedicado para la validación (conocido como modo HIL).

Contenido

- Por qué la validación de cámaras ADAS es un desafío

- Cómo habilitar la validación de cámaras ADAS usando el software de lanzamiento de ECU

- Conclusión

- Pasos siguientes

Por qué la validación de cámaras ADAS es un desafío

Los sistemas avanzados de asistencia al conductor basados en visión son una parte integral de los vehículos modernos y complementan la visión del mundo del vehículo en el espectro electromagnético visible. Proporcionan importantes funciones de autonomía, mejorando la seguridad vial a través de la planificación automatizada de la trayectoria del vehículo en base a la detección y clasificación de objetos. En el núcleo de muchas unidades de control electrónico (ECU) de ADAS se encuentra una inferencia de red neuronal (NN) aceleradora de ASIC en la entrada sensorial. Mobileye Global, Inc., proporciona uno de los chipsets más utilizados para estos subsistemas basados en NN.

Para los fabricantes y proveedores de automóviles, la validación y homologación de dichos sistemas representa una nueva clase de desafíos. De los métodos convencionales de garantía de calidad, solo las pruebas son efectivamente aplicables a las ECUs de ADAS basadas en NN. Se realizan muchas inversiones en la fase de pruebas antes de iniciar la producción del vehículo. Un enfoque popular debido a razones económicas y de reproducibilidad es la prueba funcional en un entorno basado en laboratorio, agrupando ECUs relevantes en una configuración de hardware-in-the-loop (HIL) mientras se simula el resto del bus del vehículo. Luego, el estímulo del sensor se inyecta en las ECUs en una ruta digital.

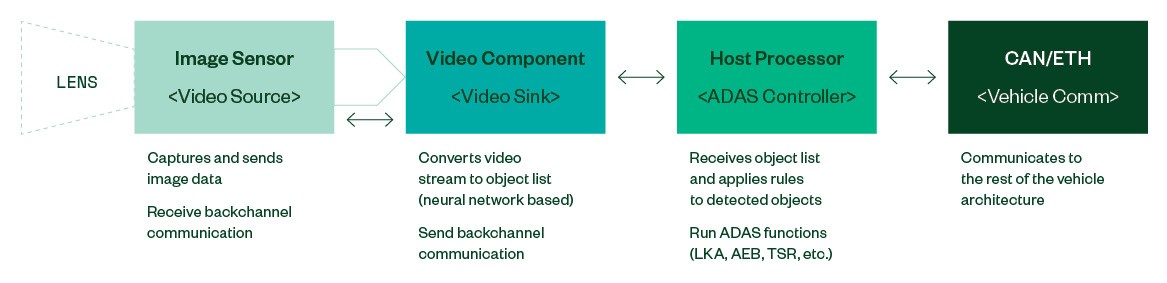

Figura 1: Arquitectura típica de un sistema de cámaras ADAS (simplificado)

Las ECUs de ADAS responsables de las funciones críticas de la seguridad del vehículo deben auto-diagnosticar las fallas y ceder el control del vehículo de manera segura (a prueba de fallas). Por lo tanto, para una ECU de visión, observar el estado operativo de los sensores de imagen y validar la transmisión de video proporcionado deben ocurrir en tiempo real.

Los sensores de imagen modernos brindan varias maneras de proteger las rutas de datos hacia y desde el procesador de video downstream contra errores: Algunos fabricantes habilitan sumas de comprobación CRC en las transacciones de canal lateral. La transmisión de video puede ser configurada para incluir contadores activos e instantáneas del estado de configuración en la imagen. Algunos sensores incluyen un pin de salida de interrupción de ERROR. La especificación MIPI CSI2 establece protecciones CRC y contadores de marcos en el nivel de protocolo.

Se emplean estas y otras medidas de seguridad para garantizar que los vehículos autónomos puedan ceder el control al conductor rápidamente para evitar seguir una trayectoria fantasma debido a fallas en la ruta de imagen. Simplemente inyectar una transmisión de video o una grabación anterior en una ECU, activará el mecanismo a prueba de fallas.

Este desafío se conoció desde el primer día y el remedio obvio fue apagar por completo el monitoreo del estado del software de la ECU y la validación del estado. Este estado se conoce mejor como "modo HIL" para las ECU de visión, y también es compatible con Mobileye y otros proveedores como Bosch o Continental. Si bien este es un mecanismo válido para habilitar la capa de percepción y las pruebas de software de aplicación, la desventaja inherente de este enfoque es que la versión del software que se está probando no es el software que se implementará en campo más adelante. Por lo tanto, las pruebas de validación omiten partes de la cobertura de la prueba, que solo están presentes en el software de producción.

Una solución aquí es realizar ingeniería inversa y emular el comportamiento del sensor de imagen en tiempo real para habilitar pruebas de software de la ECU de lanzamiento de producción.

Cómo habilitar la validación de cámaras ADAS usando el software de lanzamiento de ECU

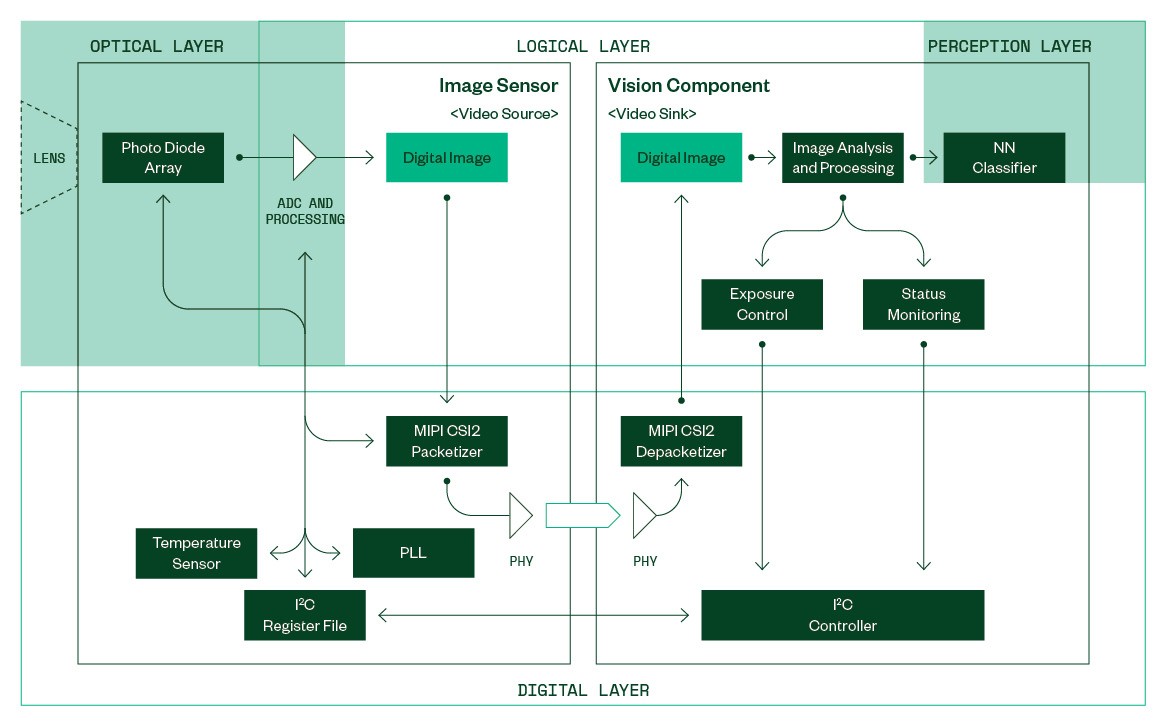

Figura 2: Vista simplificada en un sensor de imagen y un componente de visión downstream

La Figura 2 muestra un modelo conceptual simplificado de un sensor de imagen que actúa como fuente de video y un componente de visión conectado como receptor de video. En el nivel lógico, las imágenes digitales se producen en el sensor de imagen y son consumidas por el componente de visión.

Cada imagen entrante se analiza antes de enviarse a la capa de percepción. Las propiedades específicas de la imagen, como brillo medio, histograma, etc., se envían a un módulo de control responsable de ajustar el sensor de imagen para producir imágenes expuestas correctamente y adecuadas para la clasificación de objetos.

El monitoreo de estado extraerá contadores activos y validará el estado de configuración del sensor extrayendo información de los datos embebidos en la imagen. Este módulo hace que sea difícil proporcionar cualquier transmisión de video genérica a la ECU en un entorno HIL sin usar software de versión preliminar, incluyendo el "modo HIL" de la ECU.

Un sistema de inyección necesita emular el comportamiento de varios subcomponentes del sensor en tiempo real para evitar activar medidas a prueba de fallas en el componente de visión y producir resultados de pruebas confiables para el rendimiento de la detección.

La simulación de la capa óptica es el dominio de la PC principal que genera los datos de entrada del sensor. En las pruebas de regresión de ciclo abierto, una grabación anterior de una ECU de cámara similar se reproduce en el DUT. Generar datos sintéticos en vivo utilizando una herramienta de visualización permite pruebas de ciclo cerrado para exploración de escenarios, pruebas funcionales y de rendimiento. La calidad de los datos generados está directamente relacionada con la fidelidad del modelo del sensor óptico.

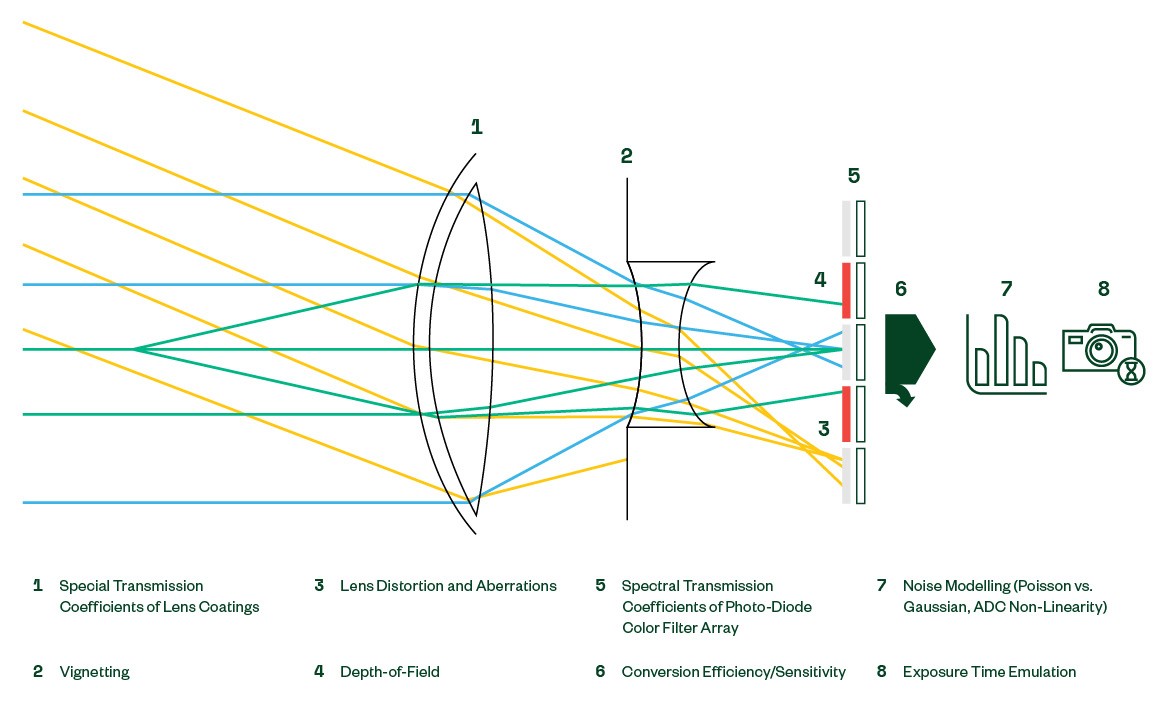

En la Figura 3 se muestran las propiedades ópticas que generalmente se cubren, en diversos grados, en una simulación sintética.

Figura 3: Efectos en la ruta optoeléctrica

En la capa lógica, la mayor parte de los esfuerzos de emulación generalmente estarán dominados por la manipulación de imágenes digitales en línea. Algunos sistemas de visión pueden hacer que el sensor recorte de manera dinámica la imagen y coloque la ventana de lectura en el arreglo de píxeles activo. Los sensores con filtros de color proporcionan amplificación de canal de color individual para ajustar el balance de blancos en diferentes entornos de iluminación.

La intensidad de la luz incidente a veces puede exceder la capacidad de los fotodiodos para capturar todo el rango dinámico de la escena, especialmente de noche. Para aumentar el rango dinámico capturado, los sensores modernos permiten varias conversiones analógicas a digitales durante el tiempo de exposición. Cada conversión individual produce 12 bits de información de brillo que luego se apilan internamente en una imagen digital final de 20 bits. Para ahorrar ancho de banda, la imagen de 20 bits se puede comprimir a 12 bits o 16 bits utilizando una función de transferencia no lineal configurable de manera dinámica.

Los procesadores downstream pueden depender de las estadísticas de imagen proporcionadas por el sensor para controlar correctamente el tiempo de exposición. Los sensores de imagen pueden generar histogramas configurables de manera dinámica con la salida de la imagen.

La capa digital está formada por protocolos de bajo nivel y parámetros eléctricos. Si bien estos también dictan el diseño de PCB para la interfaz de la ECU, los parámetros de configuración relevantes internos al sensor incluyen la configuración en línea del módulo de comunicación MIPI CSI-2 y las velocidades de reloj generadas por el ciclo de bloqueo de fase (PLL), lo que finalmente impulsa la velocidad de marco de salida. Además, se deben proporcionar salidas sensibles del archivo de registro, como lecturas de indicadores de estado y sensor de temperatura.

Los sistemas embebidos en tiempo real tienen restricciones estrictas de tiempo de diseño (latencia y rendimiento) que deben respetarse al construir interfaces de instrumentación. Además de emular funcionalmente el sensor de imagen, se debe tener mucho cuidado para reaccionar a las solicitudes y proporcionar transferencia de datos dentro de las limitaciones de tiempo del dispositivo bajo prueba.

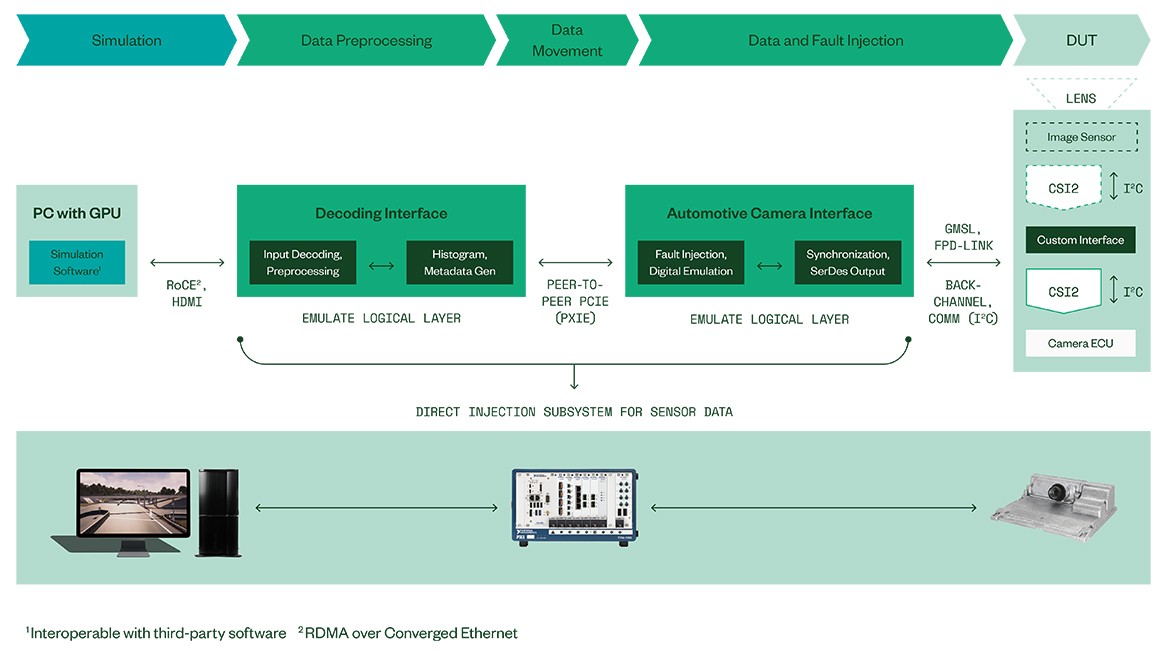

El portafolio de soluciones de NI cubre todos los temas antes mencionados proporcionando sistemas de pruebas modulares y personalizables para ECUs de ADAS/AD (ver Figura 4).

Aprovechando una sólida red de socios, NI puede proporcionar interfaces de instrumentación personalizadas para todas las ECUs, excepto las más integradas.

El núcleo en tiempo real de la IP de emulación del sensor de imagen se realiza en una plataforma de hardware escalable de alto rendimiento dedicada que es capaz de suministrar múltiples transmisiones de video UHD en paralelo, cubriendo las necesidades de los sistemas de visión de los vehículos modernos. Además, el núcleo de emulación es capaz de insertar fallas deliberadamente en varias etapas de procesamiento para permitir la cobertura de las pruebas de los mecanismos de manejo de errores en el DUT.

En el lado de la simulación, el hardware de NI proporciona escalabilidad y apertura a simulaciones de software de terceros que se pueden conectar al ciclo a través de un enlace de datos RDMA bidireccional de alto ancho de banda sobre Ethernet convergente. La compatibilidad con herramientas opcionales de simulación de terceros se obtiene adaptando las fuentes de datos HDMI.

Conclusión

Figura 4: Arquitectura del sistema HIL de NI para inyección directa de datos usando software ECU versión de producción

En resumen, las ECUs de ADAS, al ser sistemas críticos para la seguridad, utilizan medidas de seguridad de monitoreo de estado que hacen que la inyección de video sea una tarea no trivial. Se debe utilizar un modelo sofisticado de emulación de sensor de imagen en tiempo real, de múltiples capas, para satisfacer las comprobaciones de validez en la ECU y para generar transmisiones de video que provocan un comportamiento de la capa de percepción similar a la conducción de pruebas del mundo real.

La sofisticada simulación óptica y la emulación en tiempo real de NI para sensores de imagen permiten una verificación integral de las ECUs de ADAS/AD basadas en visión actual y futura en todo el mundo. Las soluciones de NI permiten pruebas de validación basadas en software de producción para ECUs de visión, lo que cierra una brecha de cobertura que ha existido desde la introducción del "modo HIL" utilizando software de versión preliminar.