Schließen einer kritischen Abdeckungslücke bei der ADAS-/AD-Kameravalidierung

Überblick

Teil unseres H1 2023 Automotive Journal

Das Testen von Produktionssoftware für kamerabasierte fortschrittliche Fahrerassistenzsysteme (ADAS) gestaltet sich aufgrund der integrierten Sicherheitsvorkehrungen zur Erfüllung funktionaler Sicherheitsanforderungen schwierig. NI biete spezielle Hardware und Software für die Emulation des Funktionsumfangs des Bildsensors auf drei verschiedenen Ebenen an, mit denen die Gültigkeitsprüfungen des zu testenden Geräts zufriedenstellend durchgeführt und ähnliche Funktionsweisen wie beim Testbetrieb stimuliert werden können. Auf diese Weise wird vermieden, dass für die Validierung eine spezielle Software im Testmodus erstellt werden muss (bekannt als HIL-Modus).

Inhalt

- Warum die Validierung von ADAS-Kameras eine Herausforderung darstellt

- Aktivieren der ADAS-Kameravalidierung mit der ECU Release Software

- Fazit

- Nächste Schritte

Warum die Validierung von ADAS-Kameras eine Herausforderung darstellt

Bildgestützte Fahrerassistenzsysteme sind ein integraler Bestandteil moderner Fahrzeuge und vervollständigen das Sichtfeld des Fahrzeugs im sichtbaren elektromagnetischen Spektrum. Sie verfügen über wichtige Autonomiefunktionen, mit denen die Sicherheit im Straßenverkehr durch die automatische Trajektorienplanung von Fahrzeugen auf der Grundlage von Objekterkennung und -klassifizierung verbessert wird. Das Herzstück vieler ADAS-Steuergeräte (Electronic Control Units, ECUs) bildet ein ASIC zur Beschleunigung der Inferenz neuronaler Netzwerke (NN) auf sensorische Eingaben. Mobileye Global, Inc., stellt einen der am häufigsten verwendeten Chipsätze für diese NN-basierten Subsysteme bereit.

Für Automobilhersteller und -zulieferer stellt die Validierung und Zulassung solcher Systeme eine neue Art von Herausforderung dar. Von herkömmlichen Methoden der Qualitätssicherung ist lediglich das Testen effektiv auf NN-basierte ADAS-Steuergeräte anwendbar. Viele Investitionen werden in der Testphase vor Beginn der Fahrzeugproduktion getätigt. Aus Gründen der Wirtschaftlichkeit und Reproduzierbarkeit ist der Ansatz des Funktionstests in einer Laborumgebung sehr beliebt. Dabei werden die relevanten Steuergeräte als Cluster in einer HIL-Anordnung (Hardware-in-the-Loop) zusammengefasst, während der restliche Fahrzeugbus simuliert wird. Der Sensorimpuls wird dann über einen digitalen Pfad in die Steuergeräte injiziert.

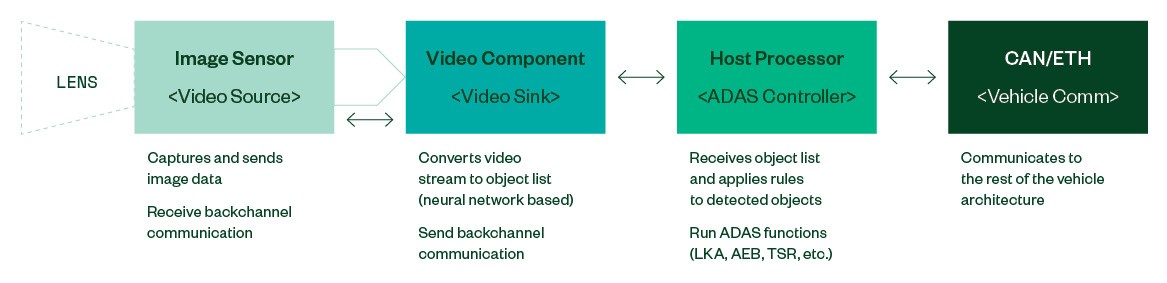

Abbildung 1: Typische Architektur eines ADAS-Kamerasystems (vereinfachte Darstellung)

ADAS-Steuergeräte, die für sicherheitskritische Fahrzeugfunktionen zuständig sind, müssen in der Lage sein, Fehler selbst zu diagnostizieren und auf sichere Art und Weise die Kontrolle über das Fahrzeug abzugeben (Failsafe). Aus diesem Grund muss ein Steuergerät für die Bildverarbeitung den Betriebsstatus des Bildsensors bzw. der Bildsensoren überwachen und den bereitgestellten Videostream in Echtzeit validieren.

Moderne Bildsensoren verfügen über mehrere Möglichkeiten, die Datenpfade zum und vom nachgeschalteten Videoprozessor gegen Fehler zu sichern: Einige Hersteller verwenden CRC-Prüfsummen für die Transaktionen im Seitenkanal. Der Videostream kann so konfiguriert werden, dass er auch Alive-Zähler und Schnappschüsse des Konfigurationszustands in das Bild einbezieht. Einige Sensoren verfügen über einen Ausgangspin für einen ERROR-Interrupt. Die Spezifikation von MIPI CSI2 sieht zusätzlich CRC-Schutz und Frame-Zähler auf Protokollebene vor.

Diese und andere Sicherheitselemente sorgen dafür, dass autonome Fahrzeuge die Kontrolle schnell an den Fahrer abgeben können, um zu vermeiden, dass sie aufgrund von Fehlern im Bildpfad einer falschen Trajektorie folgen. Das einfache Einspeisen eines Videostreams oder einer früheren Aufnahme in ein Steuergerät löst also den Failsafe-Mechanismus aus.

Dieses Problem war von Anfang an bekannt und die offensichtliche Lösung bestand darin, die Zustandsüberwachung der Steuergerätesoftware und die Statusvalidierung vollständig zu deaktivieren. Dieser Zustand ist unter dem Namen „HIL-Modus“ für Vision-Steuergeräte bekannt und wird auch von Mobileye und anderen Anbietern wie Bosch oder Continental unterstützt. Obwohl es sich hierbei um einen geeigneten Mechanismus für das Testen der Wahrnehmungsebene (Perception Layer) und der Entwicklungsumgebung handelt, besteht der Nachteil dieses Ansatzes darin, dass die getestete Softwareversion nicht die Software ist, die später im Feld eingesetzt wird. Daher fehlen bei den Validierungstests Teile der Testabdeckung, die nur in der Produktionssoftware vorhanden sind.

Eine Möglichkeit besteht darin, das Verhalten des Bildsensors in Echtzeit nachzubilden und zu emulieren, um die Software des Steuergeräts in der Produktion zu testen.

Aktivieren der ADAS-Kameravalidierung mit der ECU Release Software

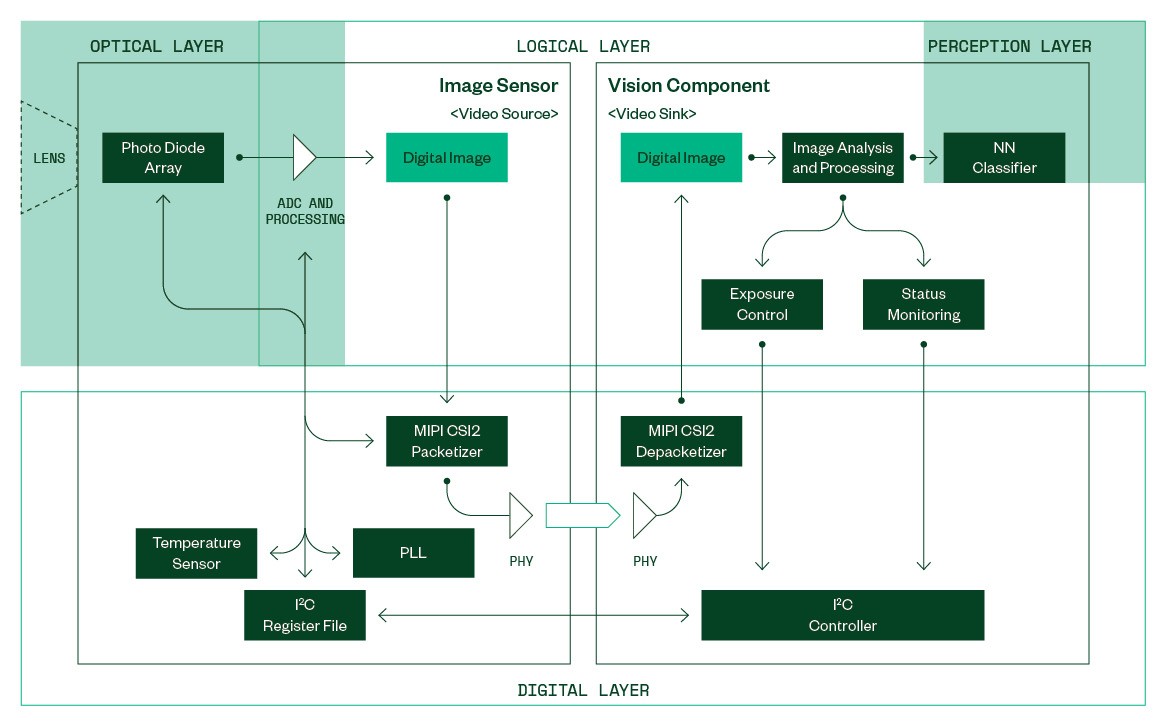

Abbildung 2: Vereinfachte Ansicht eines Bildsensors und einer nachgeschalteten Bildverarbeitungskomponente

In Abbildung 2 sehen Sie ein vereinfachtes konzeptionelles Modell eines Bildsensors, der als Videoquelle fungiert, und einer angeschlossenen Bildverarbeitungskomponente als Videosenke. Auf logischer Ebene werden digitale Bilder im Bildsensor erzeugt und von der Bildverarbeitungskomponente verarbeitet.

Jedes eingehende Bild wird analysiert, bevor es an die Wahrnehmungsebene weitergeleitet wird. Spezifische Bildeigenschaften, wie die durchschnittliche Helligkeit, das Histogramm usw., werden an ein Bedienelement weitergeleitet, welches für die Einstellung des Bildsensors verantwortlich ist, um einwandfrei belichtete Bilder für die Objektklassifizierung zu erzeugen.

Bei der Statusüberwachung werden Alive-Zähler extrahiert und der Konfigurationsstatus des Sensors überprüft, indem Informationen aus den eingebetteten Daten im Bild extrahiert werden. Mit diesem Modul ist es schwierig, dem Steuergerät in einer HIL-Umgebung einen generischen Videostream zur Verfügung zu stellen, ohne eine Vorabversion der Software zu verwenden, die einen „HIL-Modus“ für das Steuergerät enthält.

Ein Injektionssystem muss das Verhalten von mehreren Sensorteilkomponenten in Echtzeit emulieren, um das Auslösen von Failsafe-Maßnahmen in der Bildverarbeitungskomponente zu vermeiden und zuverlässige Testergebnisse hinsichtlich der Erkennungsleistung zu erzielen.

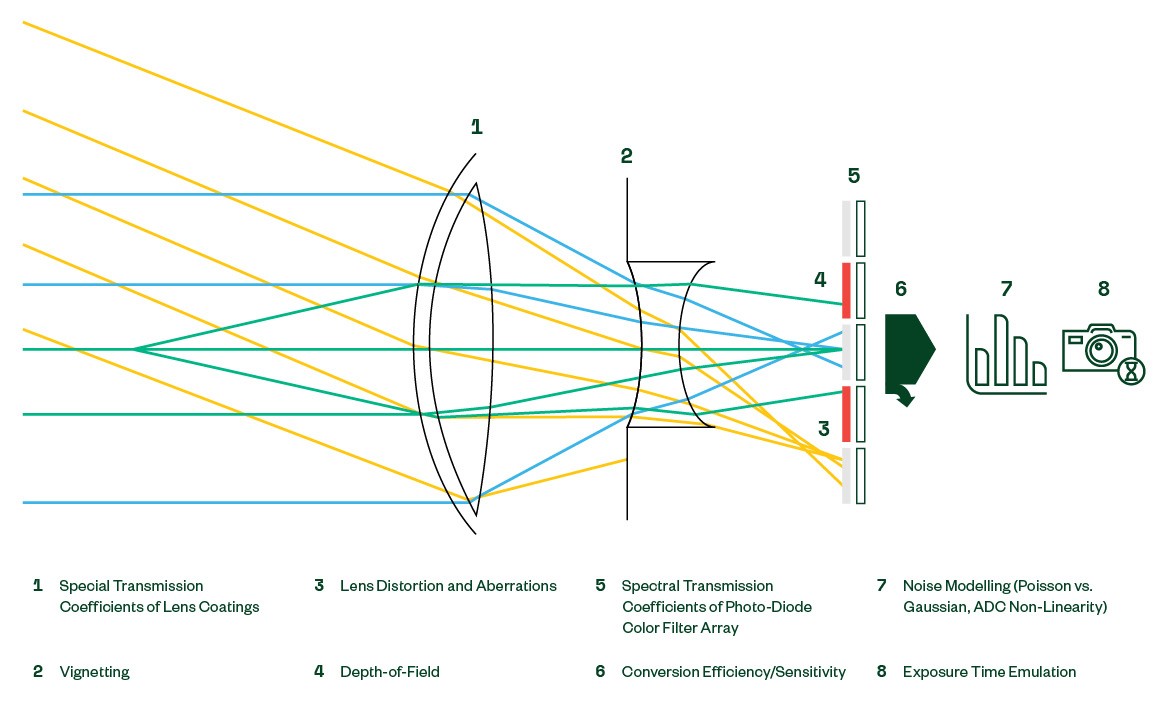

Die Simulation der optischen Schicht ist Sache des Host-Computers, der die Sensor-Eingangsdaten erzeugt. Bei Open-Loop-Regressionstests wird eine frühere Aufzeichnung von einem ähnlichen Kamera-Steuergerät auf das Testobjekt übertragen. Durch die Erzeugung synthetischer Live-Daten mit einem Visualisierungstool können Sie Tests für die Erkundung von Szenarien sowie Funktions- und Leistungstests in einem geschlossenen Kreislauf durchführen. Die Qualität der generierten Daten hängt direkt mit der Genauigkeit des optischen Sensormodells zusammen.

Die optischen Eigenschaften, die in der Regel in unterschiedlichem Maße in einer synthetischen Simulation berücksichtigt werden, sind in Abbildung 3 dargestellt.

Abbildung 3: Auswirkungen auf den opto-elektrischen Pfad

Auf logischer Ebene wird der Großteil der Emulation normalerweise von der Online-Manipulation digitaler Bilder dominiert. Bei einigen Bildverarbeitungssystemen kann der Sensor das Bild dynamisch zuschneiden und das Auslesefenster über das aktive Pixelfeld legen. Sensoren mit Farbfiltern bieten eine individuelle Farbkanalverstärkung zur Abstimmung des Weißabgleichs bei unterschiedlichen Lichtverhältnissen.

Die Intensität des einfallenden Lichts kann manchmal die Kapazität der Fotodioden übersteigen, den gesamten Dynamikbereich der Szene zu erfassen, insbesondere bei Nacht. Zur Erhöhung des erfassten Dynamikbereichs ermöglichen moderne Sensoren mehrere Analog-Digital-Wandlungen während der Belichtungszeit. Jeder einzelne Umwandlungsvorgang liefert 12 Bit an Helligkeitsinformationen, die dann intern zu einem endgültigen digitalen 20-Bit-Bild gestapelt werden. Zur Einsparung von Bandbreite kann das 20-Bit-Bild dann mithilfe einer dynamisch konfigurierbaren, nichtlinearen Übertragungsfunktion auf 12 oder 16 Bit komprimiert werden.

Nachgeschaltete Prozessoren sind möglicherweise auf die vom Sensor gelieferten Bildstatistiken angewiesen, um die Belichtungszeit korrekt zu steuern. Bildsensoren können dynamisch konfigurierbare Histogramme mit der Bildausgabe erzeugen.

Die digitale Schicht wird durch Low-Level-Protokolle und elektrische Parameter bestimmt. Obwohl diese auch das PCB-Design für die Steuergeräteschnittstelle bestimmen, gehören zu den relevanten Konfigurationsparametern innerhalb des Sensors die Online-Konfiguration des MIPI CSI-2-Kommunikationsmoduls und die von der Phasenregelschleife (PLL) erzeugten Taktraten, die letztlich ausschlaggebend für die Ausgangsbildrate sind. Zusätzlich müssen sinnvolle Ausgaben aus der Registerdatei zur Verfügung gestellt werden, wie z.B. die Anzeige von Temperatursensoren und Statusflags.

Embedded-Echtzeitsysteme unterliegen engen zeitlichen Beschränkungen (Latenz und Durchsatz), die bei der Entwicklung von Instrumentenschnittstellen beachtet werden müssen. Neben der funktionalen Emulation des Bildsensors muss auch darauf geachtet werden, dass die Reaktionen auf Anfragen und die Bereitstellung von Datenströmen innerhalb der Zeitvorgaben des zu testenden Zielgeräts liegen.

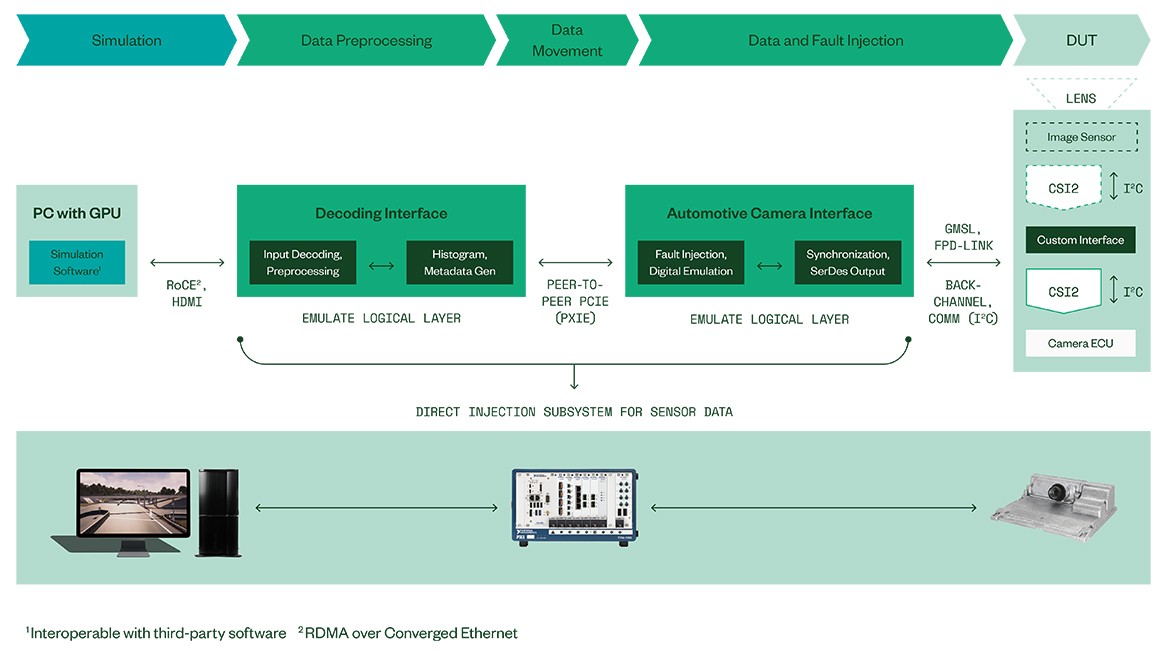

Das Lösungsportfolio von NI erstreckt sich über alle oben genannten Themen und bietet modulare und anpassbare Testsysteme für ADAS/AD-Steuergeräte (siehe Abbildung 4).

Durch die Nutzung eines starken Partnernetzwerks kann NI kundenspezifische Schnittstellen für die Instrumentierung für alle außer den am stärksten integrierten Steuergeräten anbieten.

Der Echtzeit-Kern der Bildsensor-Emulations-IP wird auf einer speziellen, hochleistungsfähigen und skalierbaren Hardware-Plattform umgesetzt, die in der Lage ist, mehrere UHD-Videostreams parallel bereitzustellen und damit den Bedarf moderner Bildverarbeitungssysteme für Fahrzeuge zu decken. Darüber hinaus ist der Emulationskern in der Lage, absichtlich Fehler in verschiedenen Verarbeitungsstufen einzufügen, um eine Testabdeckung der Fehlerbehandlungsmechanismen im Prüfling zu ermöglichen.

Auf der Simulationsebene sorgt die Hardware von NI für Skalierbarkeit und Offenheit für Software-Simulationen von Drittanbietern, die über eine bidirektionale Datenverbindung mit hoher Bandbreite mittels „RDMA over Converged Ethernet“ mit der Schleife verbunden werden können. Die Kompatibilität mit optionalen Simulationswerkzeugen von Drittanbietern ist durch die Anpassung der HDMI-Datenquellen gewährleistet.

Fazit

Abbildung 4: HIL-Systemarchitektur von NI für direkte Dateninjektion mittels serienmäßiger ECU-Software

Zusammenfassend lässt sich sagen, dass ADAS-Steuergeräte als sicherheitskritische Systeme Schutzmechanismen für die Statusüberwachung einsetzen, wodurch die Videoinjektion zu einer nicht trivialen Aufgabe wird. Ein ausgeklügeltes, mehrschichtiges Echtzeit-Bildsensor-Emulationsmodell ist erforderlich, um die Gültigkeitsprüfungen im Steuergerät zu erfüllen und Videoströme zu generieren, die auf der Wahrnehmungsebene eine Funktionsweise ähnlich der realen Testfahrt bewirken.

Die hochentwickelte optische Simulation und Echtzeitemulation von NI für Bildsensoren ermöglicht eine umfassende Verifizierung aktueller und zukünftiger bildverarbeitungsbasierter ADAS/AD-Steuergeräte weltweit. Die Lösungen von NI ermöglichten Validierungstests auf Basis von Produktionssoftware für Bildverarbeitungs-Steuergeräte. Damit wurde eine Lücke in der Abdeckung geschlossen, die seit der Einführung des „HIL-Modus“ mit Vorabversionen der Software bestand.