Altran und NI präsentieren ADAS-HIL-Simulation mit Sensorfusion

Überblick

Um die Anforderungen im Bereich autonomes Fahren zu erfüllen, sind immer häufiger HIL-Tests (Hardware in the Loop) erforderlich, mit denen die Funktionalität von Fahrerassistenzsystemen (Advanced Driver Assistance Systems, ADAS) validiert und verifiziert wird. Den Fahrerassistenzsystemen wird eine zentrale Rolle bei selbstfahrenden Fahrzeugen zugeschrieben. Das Whitepaper liefert einen Überblick über die ADAS-HIL-Simulation mit Sensorfusion, präsentiert die Ergebnisse bisheriger Forschungsarbeit und geht auf die Schlüsselkomponenten zur Implementierung der Anwendung ein.

Inhalt

- Was ist Sensorfusion?

- Wann wird Sensorfusion eingesetzt?

- ADAS-HIL-Testumgebungs-Suite (AHTES)

- Überblick auf Komponentenebene

- Fazit

- Ressourcen

Was ist Sensorfusion?

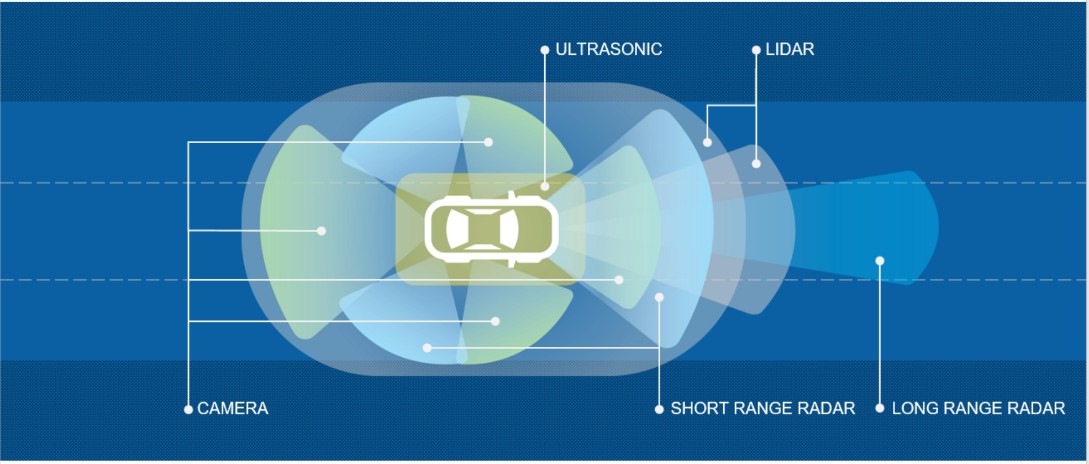

Fahrzeuge sind heutzutage mit zahlreichen Fahrerassistenzsystemen (Advanced Driver Assistance Systems, ADAS) ausgestattet, die auf unterschiedlichen Sensoren wie Radar, Kameras, LIDAR oder Ultraschall basieren. In der Regel erfüllt jeder dieser Sensoren eine bestimmte Funktion und nur in seltenen Fällen findet ein Informationsaustausch zwischen den Sensoren statt. Die Menge an Informationen, die der Treiber erhält, ist proportional zur Anzahl der verwendeten Sensoren. Wenn hinreichend Sensordaten vorhanden sind und die Kommunikation etabliert ist, kann mithilfe intelligenter Algorithmen ein autonomes System erstellt werden.

Bei Sensorfusion handelt es sich um einen Mix aus Informationen von verschiedenen Sensoren, die ein klareres Bild der näheren Umgebung liefern. Das ist eine notwendige Voraussetzung, um die Entwicklung hin zu einem verlässlicheren Funktionsumfang in Sachen Sicherheit und hin zu effektiveren Systemen für das autonome Fahren zu vollziehen.

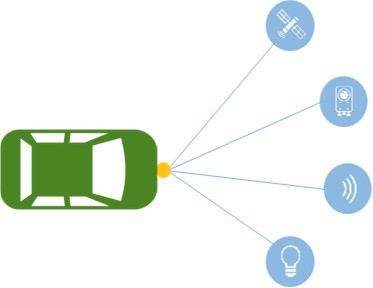

Abbildung 1: Ein „Blick“ auf die Umgebung eines Fahrzeugs

Wann wird Sensorfusion eingesetzt?

Sensorfusion kann bei allen Arten von Sensoren relevant sein. Ein typisches Beispiel ist die Fusion, also Zusammenführung, von Informationen, die von einer Frontkamera und einem Frontradar geliefert werden. Eine Kamera, die im sichtbaren Spektrum arbeitet, hat unter Bedingungen wie Regen, dichtem Nebel, grellem Sonnenlicht und fehlender Beleuchtung Probleme. Sie ist jedoch sehr zuverlässig beim Erkennen von Farben (beispielsweise Fahrbahnmarkierungen). Radar eignet sich selbst bei niedriger Auflösung zur Erkennung von Entfernungen und reagiert nicht empfindlich auf Umgebungsbedingungen.

Zu den typischen ADAS-Funktionen basierend auf der Sensorfusion von Frontkamera und -radar zählen:

- Adaptive Geschwindigkeitsregelung (Adaptive Cruise Control, ACC): Dieses System passt die Geschwindigkeit an die Verkehrsbedingungen an. Die Geschwindigkeit wird reduziert, sobald der Abstand zum vorausfahrenden Fahrzeug geringer wird als der Sicherheitsabstand. Bei freier Fahrbahn oder bei akzeptablem Abstand zum anderen Fahrzeug beschleunigt das System das Fahrzeug wieder auf die zuvor eingestellte Wunschgeschwindigkeit.

- Autonomes Notbremssystem (Autonomous Emergency Braking, AEB): Damit wird das Bremssystem gesteuert, wobei im Falle einer bevorstehenden Kollision eine Geschwindigkeitsreduzierung oder eine andere Art der Warnung des Fahrers in kritischen Situationen erfolgt.

ADAS-HIL-Testumgebungs-Suite (AHTES)

Komplexe Systeme werden in einer geeigneten Testumgebung validiert, welche die Sensoren so stimuliert, dass das Verhalten des Fahrzeugs unter realen Bedingungen verifiziert wird.

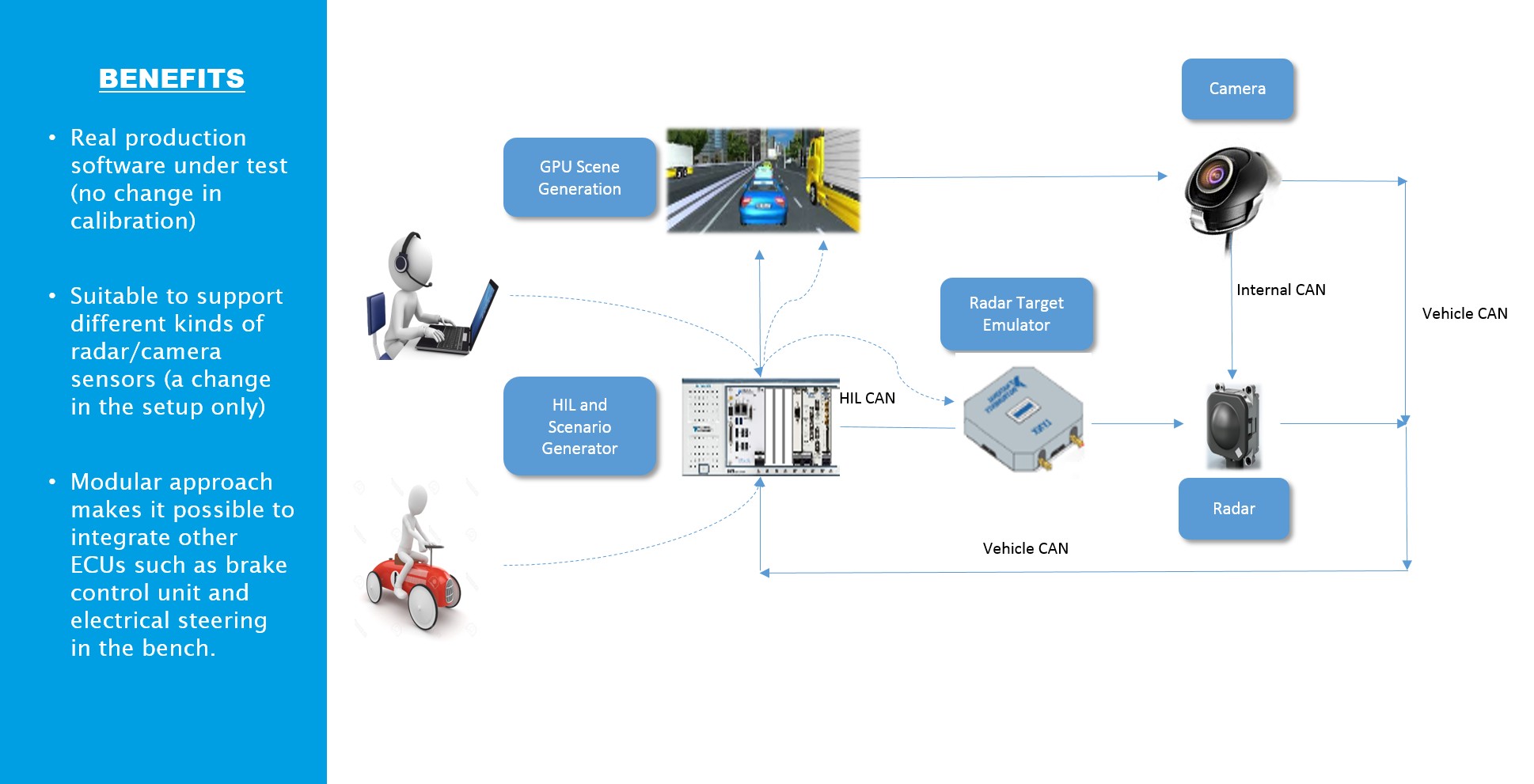

Altran Italia hat einen innovativen Radarobjektsimulator auf Grundlage von NI-Technologien sowie einen 3D-Simulator für virtuelle Straßenszenarien in einen HIL-Aufbau integriert. So entstand ein szenariobasiertes Testgerät, das Kamera- und Radardaten vollständig synchronisiert, um Algorithmen für die Sensorfusion zu validieren.

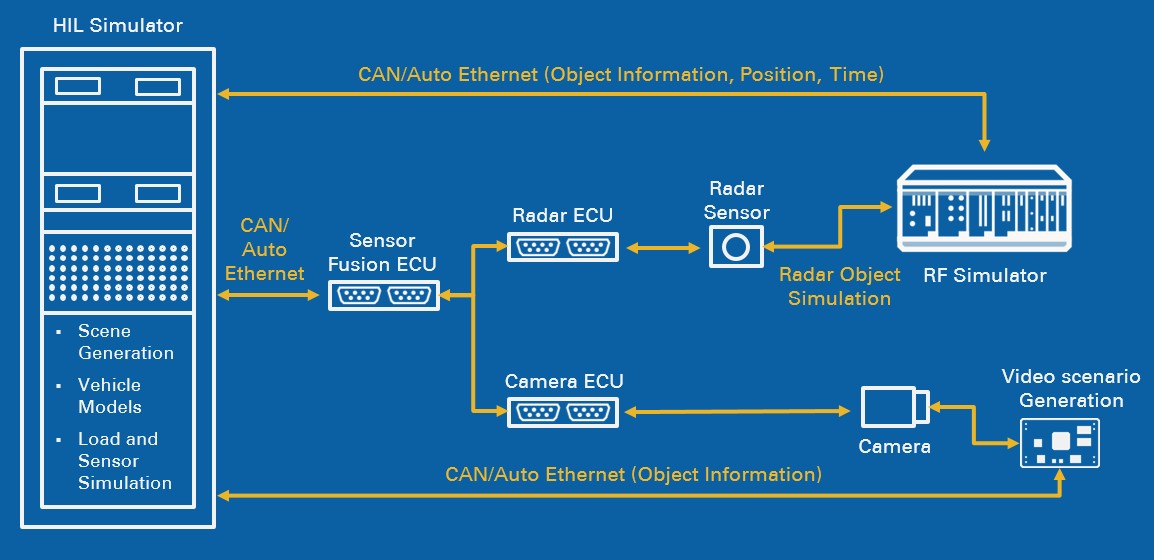

Abbildung 2: ADAS-HIL-Testlösung von Altran und NI

Das 3D-Szenario basiert auf der Unity 3D Graphic Engine, einer plattformübergreifenden Videospiel-Engine von Unity Technologies, und ist vollständig konfigurierbar, sodass die Anpassung von Parametern wie die Zahl der Fahrbahnen, der Lichtverhältnisse und des Streckentyps möglich ist. Am Markt gibt es eine Vielzahl weiterer Umgebungen, die sich auf ähnliche Weise einsetzen ließen, darunter IPG Carmaker und TASS PreScan.

Die Grafik-Engine reproduziert die Umgebung aus Sicht einer Kamera, die an der Windschutzscheibe eines Fahrzeugs angebracht ist. Die Umgebung kann entsprechend dem Abstand zum Boden und dem Sichtfeld der Kamera verändert werden. Darüber hinaus kann auch ein Hindernis (beispielsweise ein weiteres Fahrzeug) in einer bestimmten Entfernung von der Kamera mit einer festgelegten Geschwindigkeit gezeigt werden.

Abbildung 3: Szenario, das die Unity-Grafik-Engine zeigt

Zur Fahrzeugsteuerung empfängt die Grafik-Engine neben dem Lenkwinkel auch die Position des Brems- und Gaspedals. Ein PXI-System erfasst die Daten und zusätzlich Signale vom Lenkrad sowie von den Pedalen (Logitech G29). Das dynamische Fahrzeugmodell ist in die Grafik-Engine integriert und bietet ein hohes Maß an Konfigurierbarkeit.

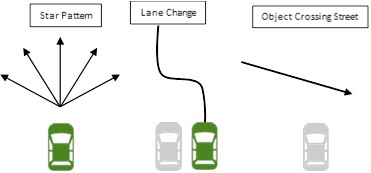

Abbildung 4: Standardmanöver

Je nach ausgewähltem Hindernisszenario (oben sind einige Beispiele als Startpunkt genannt) gibt die Grafik-Engine die Fahrzeuggeschwindigkeit sowie die vom VRTS benötigten Informationen aus, um ein RF-Signal zu erzeugen. Alle Eingabe-/Ausgangsinformationen werden mit dem PXI-System über ein proprietäres Protokoll ausgetauscht und können nach Bedarf geändert werden.

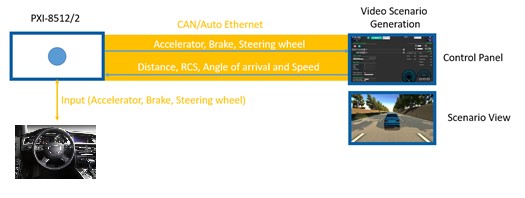

Bei diesem Aufbau wurde eine CAN-Kommunikation mit PXI-8512/2 eingesetzt, um Informationen vom Szenariogenerator über Radarziele (Entfernung, Radarrückstrahlflächen, Einfallswinkel und Geschwindigkeit) zu gewinnen. Beim PXI-8512/2 handelt es sich um eine CAN-/CAN-FD-Schnittstelle mit hohen Geschwindigkeiten und mit zwei Anschlüssen für PXI-Systeme, die CAN-Frames bei 1 Mbit/s sendet und empfängt. Die Informationen werden nur dann an den Hindernisgenerator gesendet, wenn die Angaben zu den Zielen zwischen aufeinanderfolgenden Messungen abweichen.

Die PXI-Schnittstelle sendet Daten an den Hindernissimulator und erfasst Pedal- und Lenksignale. Darüber hinaus emuliert sie CAN-Nachrichten, die über ein privates Fahrzeugnetzwerk zwischen Radar und Kamera ausgetauscht werden.

CAN-Nachrichten werden mithilfe des virtuellen 3D-Szenarios und des RF-Zielgenerators synchronisiert, um die geeignete Umgebung zur Validierung der Daten von modernen Kameras und Radargeräten zu schaffen.

Überblick auf Komponentenebene

Nachfolgend finden Sie einen kurzen Abriss über alle Systemkomponenten und Kommunikationsverbindungen bzw. -busse.

- Radar Engine Control Unit (ECU): Mit dem Radarsensor werden vor allem Objekte erkannt und deren Geschwindigkeit sowie Position im Verhältnis zur Bewegung des mit Radar ausgestatteten Host-Fahrzeugs gemessen. Beim Radarsensor handelt es sich um ein monostatisches multimodales Radar, das mit sechs festen Radarantennen das 76-GHz-Frequenzband nutzt. Der Sensor kann andere Fahrzeuge auf eine Entfernung von etwa 250 Metern erkennen. Das Radar ist mit einem beheizten Objektiv ausgestattet, das selbst bei schlechten Witterungsbedingungen wie Schnee und Eis für eine vollständige Verfügbarkeit des Sensors sorgt. Die relative Geschwindigkeit von Objekten wird mithilfe des Doppler-Effekts gemessen (der Frequenzverschiebung zwischen reflektierten und gesendeten Signalen). Die Entfernung zum Objekt lässt sich mithilfe der Zeitverzögerung bestimmen.

Die Sensorfusion mit den Informationen der Kamera findet in der ECU statt. Die ECU übernimmt beispielsweise die adaptive Geschwindigkeitsregelung und das autonome Notbremssystem.

- Kamera-ECU: Die Kamera-Steuereinheit erfasst Bilder der näheren Umgebung und liefert verschiedene Informationen, beispielsweise den Abstand zu Fahrbahnmarkierungen und anderen Objekten. Diese Informationen werden zur Sensorfusion an die Radar-ECU gesendet. In manchen Fällen (beispielsweise im Fall von Verkehrszeichen und beim Halten der Fahrspur) arbeitet die Kamera-ECU aber auch eigenständig. In dem Fall sendet die ECU CAN-Nachrichten über den Fahrzeug-CAN-Bus, den Vehicular CAN.

- Video Scenario Generation: Hierbei handelt es sich um einen Simulator mit einem Fahrzeugsystem, der über CAN-Kommunikation Input von der Schnittstelle PXI-8512/2 erhält und Informationen über die simulierte Umgebung überträgt. Während der Simulation werden Radardaten wie Entfernung, Radarrückstrahlung, Einfallswinkel und Geschwindigkeit erzeugt und auf Grundlage des Videoszenarios in Echtzeit berechnet. Über das Bedienpanel (zweiter Bildschirm) können Anwender die Verbindung mit dem PXI-8521/2 steuern, Witterungsbedingungen ändern, Radarpositionen anpassen und ein neues Fahrzeug mit festgelegter Geschwindigkeit und Entfernung auf den Weg bringen.

Abbildung 5: Emulation der Fahrzeugkommunikation

Der Simulator wurde mithilfe der Unity 3D Graphic Engine entwickelt, einer plattformübergreifenden Videospiel-Engine von Unity Technologies. Ein modularer Ansatz erlaubt die einfache Integration des Videoszenarios in Drittanbieterplattformen, Plugins oder Geräte, wie das in Abbildung 5 gezeigte Logitech G29.

Abbildung 6: ADAS-HIL-Testumgebung

Der Radarobjektsimulator wird innerhalb des HIL-Systems für Tests und Messungen eingesetzt. Dank der Flexibilität, Modularität und Skalierbarkeit des NI-Systems ist eine einfache Integration in andere I/O-Systeme möglich, sodass es als Teil eines umfangreichen HIL-Testgeräts für den Entwurf und Test von Radaranwendungen dienen kann. Außerdem kann dasselbe System für die Emulation von Zielgeräten und Radargerätemessungen verwendet werden, was die Kosten für Geräte- und Systemtests verringert.

Das System ermöglicht:

- RF-Messungen zur Verifizierung der Sensorleistung

- Signalanalysen: äquivalente isotrope Strahlungsleistung (EIRP), Rauschen, Strahlbreite und Frequenz

- Chirp-Analyse: Linearität, Übersteuern, Aufzeichnen und Tagging

- Radarzielsimulator zur Funktionsverifikation von Sensoren

- Einzelne und mehrere Ziele

- Festgelegte und variable Abstände

- Szenarien mit mehreren Objekten (Entfernung, Geschwindigkeit, Größe und Einfallswinkel)

- Benutzerdefinierbare Zielszenarien

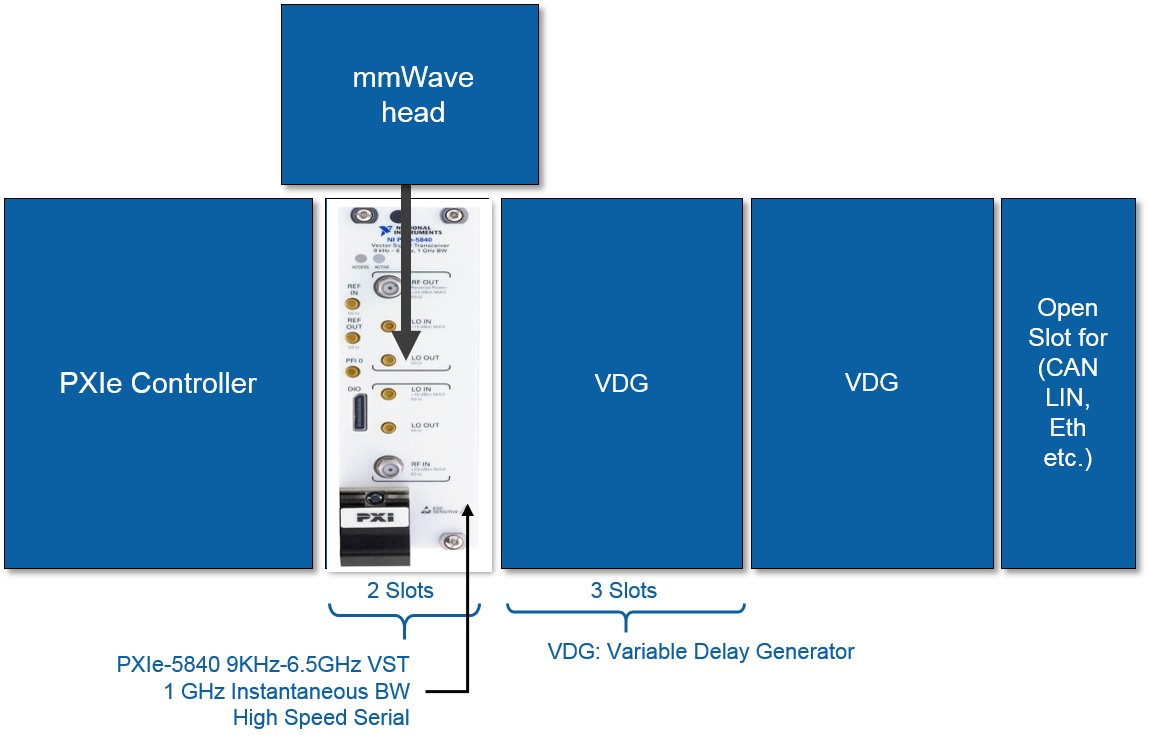

Abbildung 7: Systemarchitektur mit zwei Zielen und einem Winkel

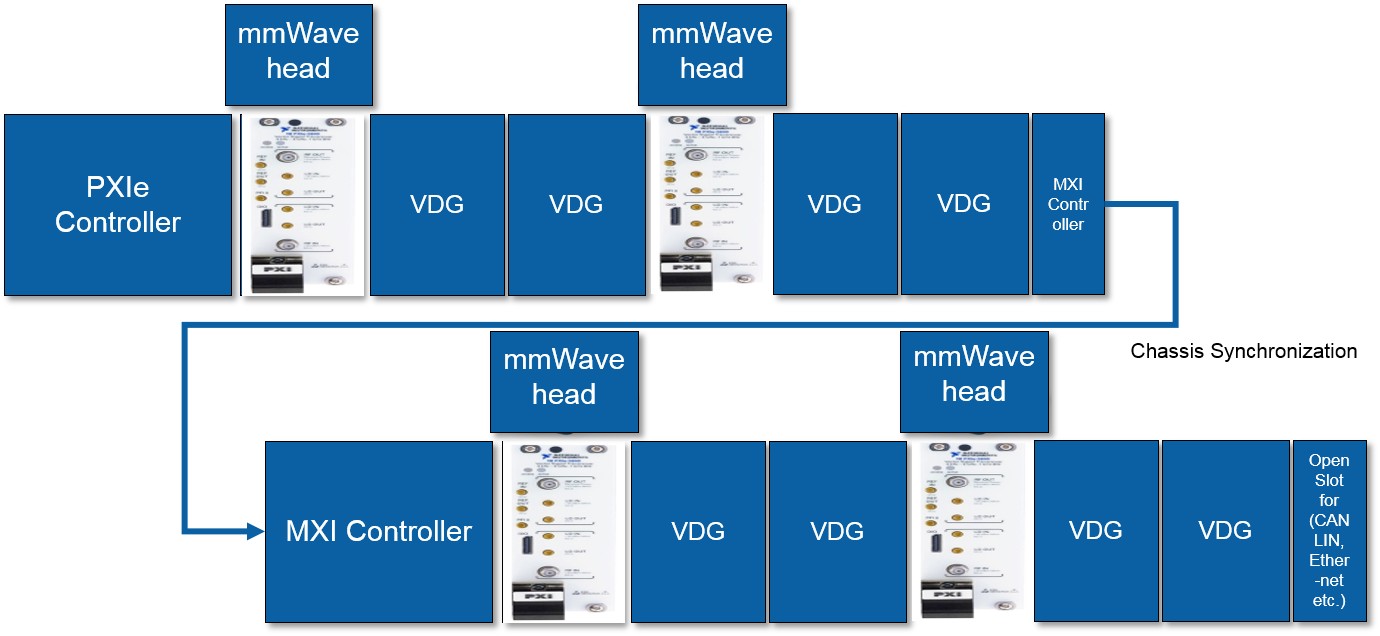

Abbildung 7 zeigt den Aufbau mit einem Vektorsignal-Transceiver des Typs PXIe-5840 und einem mm-Wellen-Funkempfänger. Damit können zwei Ziele mit demselben Einfallswinkel erzeugt werden. Die Flexibilität der PXI-Plattform hat eine einfache Erweiterung des Systems auf mehrere Ziele mit mehreren Einfallswinkeln ermöglicht. Abbildung 8 zeigt die Konfiguration mit vier PXIe-5840-Geräten und vier mm-Wellen-Funkempfängern. Diese Konfiguration ermöglicht, bis zu acht verschiedene Ziele mit vier Einfallswinkeln zu simulieren.

Abbildung 8: Systemarchitektur mit acht Zielen und vier Winkeln

Das Chassis mit dem Radarobjektsimulator kann mithilfe gängiger Kommunikationsbusse (CAN oder LIN) für den Automobilbereich und anderer in der Industrie üblichen Kommunikationstechnik integriert werden, die für das HIL-System erforderlich ist. Die modulare Lösung erlaubt Automobilbauern das Testen komplexer alltäglicher Szenarien, in denen mehrere Einfallswinkel getestet werden können. In den NCAP-Richtlinien (New Car Assessment Program) enthaltene Standardmanöver können automatisch getestet werden, was Zeit und Aufwand spart.

Fazit

Altran hat gezeigt, dass es inzwischen möglich ist, Laborvalidierungen von Systemen wie RADAR und Kameras durchzuführen, die eigenständig oder als integrierter Bestandteil arbeiten.

Beide Komponenten spielen eine wichtige Rolle bei der Sicherheit. Daher ist die Möglichkeit, sie im Labor noch vor den Fahrzeugtests prüfen zu können, ein entscheidender Schritt.

Eine Validierung auf diese Art und Weise hat folgende Vorteile:

- Sie bietet die Möglichkeit, die Validierung in einen Stadium vor Verfügbarkeit des Fahrzeugs vorwegzunehmen, sodass Maßnahmen ergriffen werden können, die andernfalls zu spät kämen.

- Die Gesamtentwicklungszeit wird stark verkürzt, da Tests schon begonnen werden können, bevor das Fahrzeug verfügbar ist.

- Durch ein System, das im Dauereinsatz arbeiten kann, werden die Entwicklungskosten reduziert.

- No-Regression Tests können im Vergleich zum Einsatz des bereits montierten Fahrzeugs in viel kürzerer Zeit und zu minimalen Kosten durchgeführt werden.

Zwar wurde die auf Grundlage von NI-Hard- und -Software von Altran erstellte ADAS-HIL-Testumgebungs-Suite für die Verifizierung und Validierung konzipiert, jedoch ist ihr Einsatz nicht auf diesen Bereich beschränkt. Die Suite kann auch zur Kalibrierung von ECUs verwendet werden, um Parameter für Fahrzeugtests zu ermitteln.

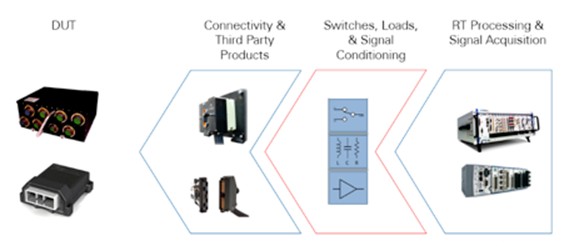

Fahrerassistenzsysteme können vollständig in andere NI-Hardwareprodukte für HIL integriert werden, darunter SLSC-Hardware (Switch Load Signal Conditioning) zum Standardisieren und Routen von Signalen, zum Schalten von Lasten und zur Signalaufbereitung. Mithilfe der Softwareumgebung VeriStand für Echtzeittestanwendungen kann jede Komponente in ein Framework integriert werden, das mit echtzeitfähigen HIL-Systemen interagieren kann.

Abbildung 9: So passt SLSC in ein HIL-System

NI hat seine Plattform um ein Ökosystem aus branchenweit führenden Partnern im Bereich vernetzter Fahrzeuge und moderner Fahrzeugtechnik erweitert, die Anwender bei Infotainment-Tests, Tests von Batteriemanagementsystemen, Car2X-Kommunikationtechnologien und NVH-Analysen unterstützen.

Abbildung 10: Car2X, Lidar und GNSS für das vernetzte Fahrzeug

Autoren

Mario Amoruso (National Instruments)

Stefano Caiola (National Instruments)

Giuseppe Doronzo (Altran Italia)

Marino Difino (Altran Italia)

Begutachtung

Ram Mirwani (National Instruments)

Matteo Moriotti, Altran Italia

Davide Palandella (National Instruments)

Ressourcen

- Altran Group

- Einsatz der SLSC-Architektur zur Erweiterung des Signalpfads eines Prüfsystems um zusätzliche Elemente (engl.)

Über Altran

Als weltweit führender Anbieter für Engineering- und F&E-Serviceleistungen (ER&D) hat Altran eine völlig neue Methode für seine Kunden konzipiert, um Innovationen umzusetzen. Dazu entwickelt das Unternehmen die Produkte und Services von morgen. Altran arbeitet mit seinen Kunden an der gesamten Wertschöpfungskette ihres Projekts zusammen, von der Planung bis zur Umsetzung in der Industrie.

Seit über 30 Jahren stellt die Gruppe großen Unternehmen in Bereichen wie Luft- und Raumfahrt, Automobil, Verteidigung, Energie, Finanzen, Life Sciences, Schienenverkehr und Telekommunikation ihr Know-how zur Verfügung.

2016 erwirtschaftete die Altran Gruppe einen Umsatz von EUR 2,12 Mrd. Mit mehr als 30.000 Beschäftigten ist Altran in mehr als 20 Ländern vertreten.

Altran ist seit 1996 in Italien vertreten und beschäftigt dort derzeit über 2.800 Mitarbeiter. Es hat seinen Hauptsitz in Rom und ist in weiten Teilen des Landes vertreten: Genua, Turin, Mailand, Trieste, Verona, Padua, Bologna, Modena, Pisa, Florenz, Neapel, Pomigliano und Brindisi. 2015 lag der von der Gruppe generierte Umsatz bei EUR 208 Mio.

altran.com und altran.it